Courtesy of QuantaMagazine

Model Bahasa Kecil: Solusi Hemat Energi dan Biaya untuk AI Canggih

10 Mar 2025, 07.00 WIB

40 dibaca

Share

Ikhtisar 15 Detik

- Model bahasa kecil dapat melakukan tugas spesifik dengan efisien dan hemat sumber daya.

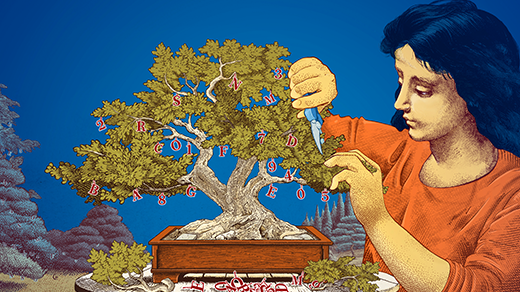

- Proses distilasi pengetahuan memungkinkan model besar untuk mentransfer pengetahuan ke model kecil.

- Pemangkasan dapat meningkatkan efisiensi model bahasa dengan menghilangkan parameter yang tidak perlu.

Model bahasa besar (LLM) seperti yang dibuat oleh OpenAI dan Google sangat kuat karena memiliki ratusan miliar "parameter" yang membantu mereka mengenali pola dalam data. Namun, melatih model sebesar itu membutuhkan banyak sumber daya komputer dan energi, sehingga beberapa peneliti mulai mengembangkan model bahasa kecil (SLM) yang hanya menggunakan beberapa miliar parameter. Meskipun tidak sekuat LLM, SLM dapat melakukan tugas tertentu dengan baik, seperti menjawab pertanyaan atau merangkum percakapan, dan dapat dijalankan di perangkat seperti laptop atau ponsel.

Untuk membuat SLM lebih efektif, peneliti menggunakan teknik seperti "penyulingan pengetahuan," di mana model besar membantu melatih model kecil dengan memberikan data berkualitas tinggi. Selain itu, mereka juga menggunakan metode "pemangkasan" untuk menghapus bagian-bagian yang tidak perlu dari model besar. Model kecil ini lebih mudah untuk diteliti dan lebih murah untuk dilatih, sehingga bisa menjadi pilihan yang baik untuk banyak pengguna yang tidak memerlukan model besar.

Referensi:

[1] https://www.quantamagazine.org/why-do-researchers-care-about-small-language-models-20250310/

[1] https://www.quantamagazine.org/why-do-researchers-care-about-small-language-models-20250310/

Analisis Ahli

Zico Kolter

"Model dengan 8 miliar parameter sudah cukup efektif untuk banyak aplikasi khusus, memberikan solusi praktis yang hemat sumber daya."

Yann LeCun

"Pruning bisa menghilangkan hingga 90% parameter tanpa kehilangan performa, menunjukkan efisiensi besar dalam desain model."

Leshem Choshen

"Model kecil memungkinkan eksperimen yang lebih murah dan transparan, membantu inovasi dalam pengembangan AI."

Analisis Kami

"Pendekatan menggunakan model kecil adalah langkah penting untuk mendemokratisasi teknologi AI dengan mengurangi hambatan biaya dan sumber daya. Namun, kita harus tetap berhati-hati agar optimasi tersebut tidak mengorbankan kemampuan model dalam memahami konteks yang lebih luas."

Prediksi Kami

Model bahasa kecil akan semakin populer untuk aplikasi khusus karena efisiensi biaya dan energi, sementara model besar masih digunakan untuk aplikasi umum yang kompleks.

Pertanyaan Terkait

Q

Apa yang dimaksud dengan model bahasa besar (LLM)?A

Model bahasa besar (LLM) adalah model yang memiliki ratusan miliar parameter dan digunakan untuk mengidentifikasi pola dalam data.Q

Mengapa model bahasa kecil (SLM) menjadi populer?A

Model bahasa kecil (SLM) menjadi populer karena mereka lebih efisien dalam hal komputasi dan dapat digunakan untuk tugas-tugas spesifik.Q

Apa itu distilasi pengetahuan dalam konteks model bahasa?A

Distilasi pengetahuan adalah proses di mana model besar mengajarkan model kecil menggunakan data berkualitas tinggi.Q

Siapa Yann LeCun dan apa kontribusinya terhadap model bahasa?A

Yann LeCun adalah ilmuwan komputer yang mengembangkan metode pemangkasan untuk meningkatkan efisiensi model bahasa.Q

Apa keuntungan dari menggunakan model bahasa kecil dibandingkan model besar?A

Keuntungan dari menggunakan model bahasa kecil adalah mereka lebih hemat biaya, waktu, dan sumber daya komputasi.